מסקר שערכנו בשיתוף מכון גיאוקרטוגרפיה ומהווה מדגם מייצג של האוכלוסייה בישראל עולה כי כ-70% מהציבור מכיר כלים של בינה מלאכותית, כאשר ChatGPT הוא הכלי המוכר ביותר (59%) ולאחר מכן Bard עם 12%, Dall-E2 עם 12%, Midjourny עם 11% ו- Canva Magic write עם 10%.

כ-47% מהציבור כבר התנסה בכלים השונים של בינה מלאכותית, כאשר מרביתם התנסו ב-ChatGPT ובעיקר בקרב צעירים מהמגזר החילוני.

באופן כללי, צעירים מכירים יותר כלים של בינה מלאכותית לעומת מבוגרים כאשר רק מחצית מגילאי 55 ומעלה מכירים את הכלים השונים.

מתוך הקהל שמכיר ושמע על כלים של בינה מלאכותית, כ-57% כבר התנסו ב-ChatGPT.

ולאילו מטרות משתמשים בבינה מלאכותית?

שלוש המטרות העיקריות לשימוש בכלים של בינה מלאכותית ועם אחוזי שימוש דומים הן לצרכי פנאי (45%), עבודה (44%) ולימודים (42%) ולאחר מכן לשימושים פיננסים (12%) או נושאי בריאות (12$).

מעל מחצית מהציבור (57%) מסכימים עם התפיסה כי שימוש בכלים של בינה מלאכותית במקום העבודה יכול לקצר תהליכים.

האם בינה מלאכותית תקדם או תזיק לאנושות?

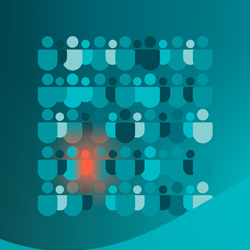

מעל לשליש מהציבור סבורים כי השימוש בבינה מלאכותית יקדם את האנושות (40%), וכשליש סבורים כי יזיק (31%).

בקרב אלו שהתנסו כבר בכלים השונים, השיעורים מעט שונים כש-54% סבורים שהבינה המלאכותית תקדם את האנושות בעוד 22% סבורים כי היא תזיק.

ומה עם אבטחת מידע?

אחד הנושאים שעולים הוא כל מה שקשור לפרטיות המידע. מערכות מבוססות AI נשענות על שימוש רחב מאוד בנתונים ובגישה למידע אישי ורגיש כדי לאמן ולשפר אלגוריתמים. איסוף, אחסון ושימוש בנתונים אלו מעלים שאלות קשות של פרטיות.

מהסקר שבוצע עולה כי רק 35% מהנשאלים סבורים כי שימוש בכלים של בינה מלאכותית במקום העבודה יכול לפגוע באבטחת המידע.

אדם שעושה שימוש ב-GPT למשל, משתף עם הבוט מידע רחב, לעתים שעלול להיות סודי או אישי, או אפילו מקצועי אם זה נעשה בהקשר של עבודה. מערכות הבינה המלאכותית יכולות להשתמש במידע שנחלק איתן להציע שירותים או תובנות לגופים אחרים.

הפער בין הסיכונים הקיימים לכך שרק כשליש סבור שאכן השימוש עלול לפגוע באבטחת המידע בארגון מוביל לכך שהחברות חייבות לבחון דרכים להגנה על המידע הרגיש מפני דליפה, ולמעשה כיום כבר ישנן חברות שאוסרות על העובדים להשתמש במערכות כמו GPT למטרות עבודה.

גם ההאקרים כבר מכירים את היכולות של מערכות בינה מלאכותית. אם בעבר היה דרוש ידע מסוים על מנת לבצע מתקפה, היום כל הידע נגיש לכל אחד בלחיצת כפתור. אם המידע הרגיש לא מוגן כראוי, ניתן לפגוע בו ובכך להוביל לגניבת זהות, הונאה או גישה לא מורשית למידע נוסף.

בחודש יוני האחרון דווח (Bleeping Computer) כי יותר מ-100,000 חשבונות משתמש ChatGPT נגנבו על ידי תוכנות זדוניות גונבות מידע במהלך השנה האחרונה.

ייתכן שאנשים לא יבינו שחשבונות ChatGPT שלהם עשויים למעשה להכיל כמות גדולה של מידע רגיש שמבוקש על ידי פושעי סייבר. פלטפורמה מהסוג הזה מאחסנת את כל בקשות הקלט כברירת מחדל ובעלי גישה לחשבון יכולים לצפות בו.

נוזקות לגניבת מידע הופכות בולטות יותר בגישה לנתונים של ChatGPT ואף משמשות לעתים קרובות ככלי במתקפות שניתנות כשירות.

ככל שהצ'אטבוטים מוזנים ביותר ויותר נתונים, כך הם יהיו אטרקטיביים יותר עבור גורמי איומים ולכן מומלץ גם לחשוב היטב איזה מידע אנחנו מזינים לצ'אטבוטים מבוססי ענן ושירותים אחרים.